какие данные проверяются при индексации сайта

Какие данные проверяются при индексации сайта

В поисковую базу попадают не все страницы сайтов.

Причины могут быть разные. Например, поисковая система посчитала страницу дубликатом или поисковый робот просто не успел до нее добраться. Насколько полно проиндексирован ваш сайт, можно узнать на сервисе Яндекс.Вебмастер. Он покажет, сколько страниц проиндексировано и сколько из них попало в поиск. Вы сможете узнать также тематический индекс цитирования ресурса (тИЦ).

На сервисе Яндекс.Вебмастер можно увидеть основные показатели индексирования сайта.

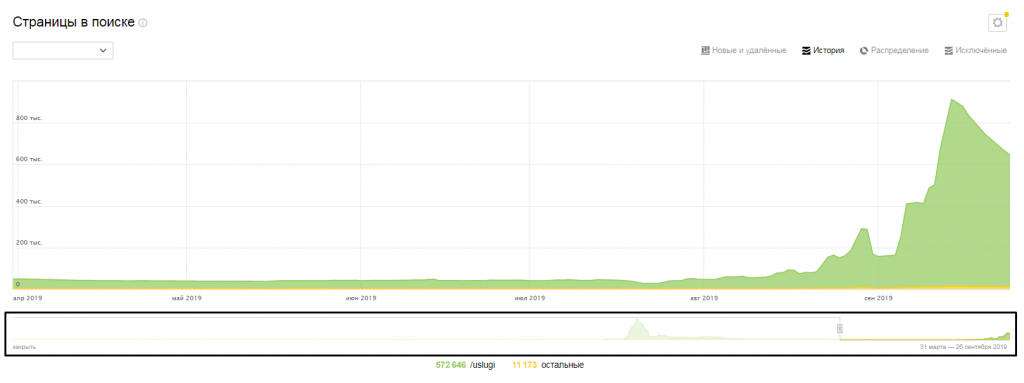

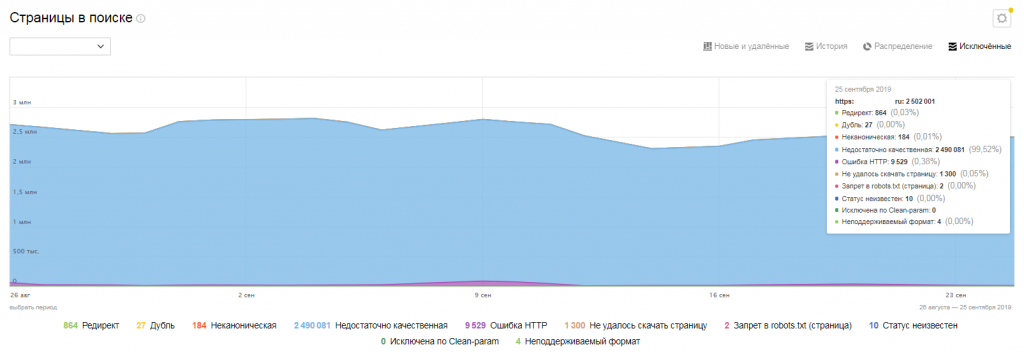

Так, «Страницы в поиске», как и следует из названия, показывает, сколько страниц сейчас присутствует в поиске.

Показатель «Загруженные страницы» говорит о том, сколько страниц обошел поисковый робот. Таких страниц обычно гораздо больше, чем доступных в поиске. Дело в том, что часть страниц по разным причинам не попадают в поиск — например, если поисковая система считает их недостаточно качественными.

Какие страницы робот не стал добавлять в базу, можно узнать, перейдя по ссылке «Исключённые страницы». Чаще всего в этот список попадают страницы, которые отвечают ошибкой, удалены или запрещены к индексированию в robot.txt. Вы можете посмотреть, не оказалось ли среди них полезных и важных страниц.

Здесь же можно увидеть количество ссылок на ваш ресурс и тИЦ — тематический индекс цитирования. Они косвенно показывают авторитетность вашего ресурса.

Показатели индексирования сайта постоянно меняются.

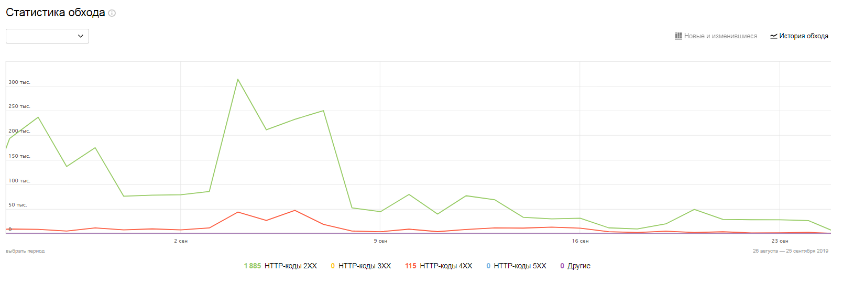

Следить за изменениями можно в разделе «Индексирование» — «Статистика обхода».

Это помогает увидеть тенденции и вовремя на них отреагировать. Так, в большинстве случаев незначительное уменьшение количества страниц в поиске не должно вызывать беспокойства. Однако если при этом снижается количество переходов на сайт, лучше убедиться, что из поиска не выпали действительно важные и нужные людям страницы.

Графики позволяют понять также, успевает ли поиск за изменениями на сайте. Например, если вы добавили на свой ресурс несколько новых разделов, на графиках должен быть виден рост числа проиндексированных страниц. Если это не так, значит, новые разделы пока не доступны пользователям поиска.

Оцените динамику индексирования вашего сайта с помощью «Статистики» на Яндекс.Вебмастере. В чем причина такой динамики?

Как проиндексировать сайт в Яндексе, Google и других поисковиках

Индексирование сайта — что это и для чего необходимо?

Индексация сайта в поисковых системах — необходимое условие его видимости при поиске в интернете. Если просто создать сайт и не заботиться о его индексации, скорее всего, на него смогут попасть только те, кто знает непосредственный адрес домена.

Индексирование — это процесс считывания страниц сайта роботом той или иной поисковой системы с последующим добавлением данных страниц в базу поисковой системы

Краулеры с некоторой периодичностью обходят страницы сайта, считывая

И множество других данных.

Благодаря тому, что поисковая система узнаёт о сайте, она способна предлагать и продвигать его в результатах поиска. На основе контента, ссылок и ряда факторов определяется тематическая категория сайта, ключевые фразы, по которым он наиболее релевантен поисковым запросам.

Таким образом, поисковая система предлагает пользователям страницы вашего сайта, максимально соответствующие их запросам.

Индексация всего лишь способствует актуализации материалов сайта. Благодаря этому страницы и их содержимое, во-первых, попадают в поисковую выдачу с наименьшей задержкой. А, во-вторых, постоянно обновляются.

Как эффективно проиндексировать сайт

Чтобы сайт как можно быстрее начали индексировать поисковые системы, его надо добавить в базу поисковиков через инструменты для вебмастеров.

Добавьте сайт в Яндекс.Вебмастер

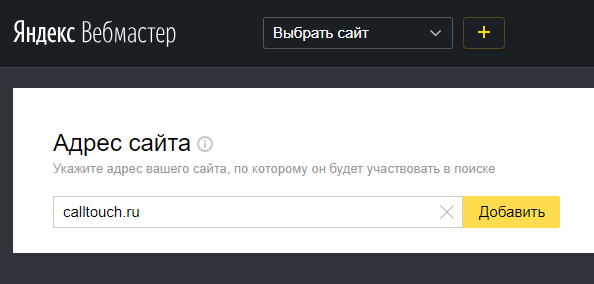

Простой ответ на вопрос «Как проиндексировать сайт в Яндексе?» — добавить его в Вебмастер.

В том же меню есть информация о том, когда и с каким результатом робот обходил страницы, какие из них есть в поиске, а также функция добавления Sitemap, запуска переобхода и настройки скорости обхода.

Добавьте сайт в Google Search Console

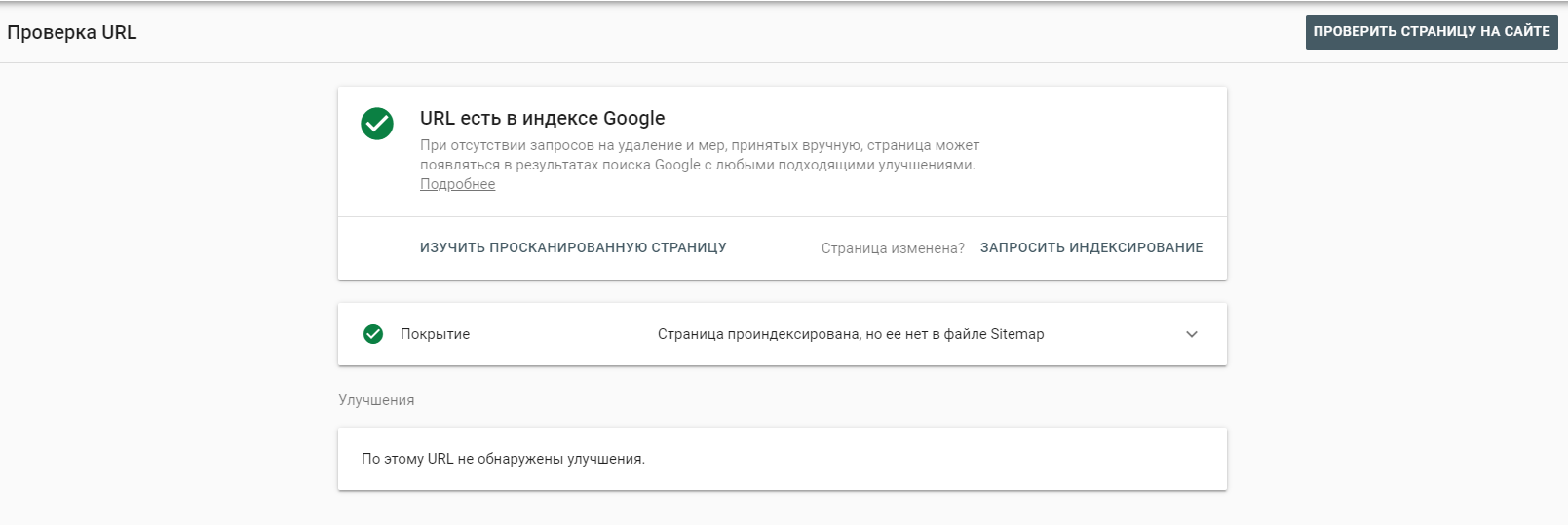

Перейдите на https://search.google.com/search-console/welcome и войдите в учётную запись. Добавьте сайт в систему.

Как и в Яндекс.Вебмастере, инструмент предлагает множество отчётов о состоянии индексации сайта. Вы может увидеть, какие страницы проиндексированы и добавлены в поиск, внутренние и внешние ссылки и многое другое.

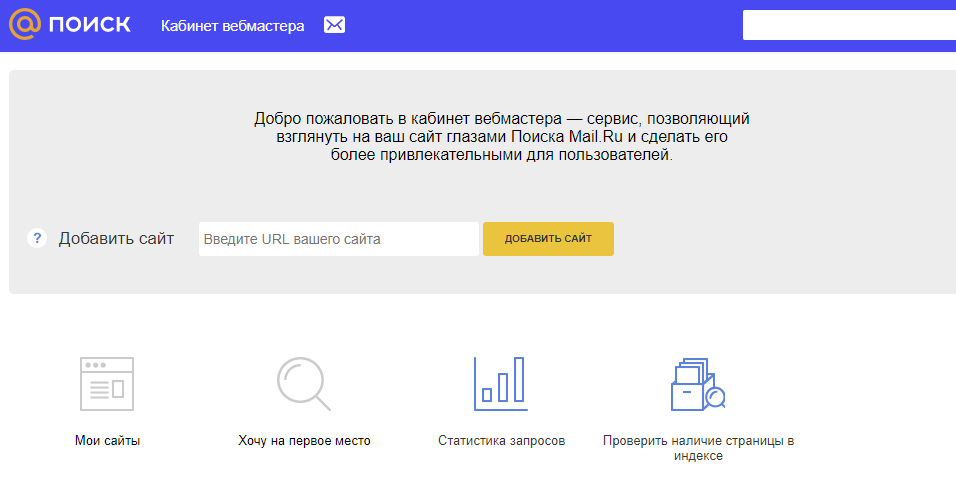

Добавление сайта в прочие поисковые системы

В российском сегменте интернета доля поисковых систем помимо Яндекса и Google стремится к нулю. Тем не менее, не следует ими пренебрегать, если сайт является важным имиджевым элементом крупного проекта или организации.

Рамблер основан на тех же данных индексации, которые собирает Яндекс — в этом случае нет необходимости в дополнительных настройках.

Как ускорить индексацию сайта в поисковиках

Создайте файл robots.txt

Файл robots.txt даёт поисковым роботам указание — какие страницы и разделы сайта следует читать, а какие — нет.

На сайте всегда присутствуют технические страницы — в частности, результаты поиска, этапы регистрации, системные файлы, теги и подобное. Также со временем может скопиться некоторый объём неактуальных страниц — контент на них может быть устаревшим или наоборот, он ждёт публикации не ранее назначенной даты.

Что такое индексация сайта в поисковых системах

Под индексированием понимается процесс сканирования страниц сайта роботом поисковой системы (ПС) и их дальнейшее добавление в базу данных, которая называется Индексом. Индекс необходим для поиска страниц сайтов с корректным ответом на запросы пользователей поисковика. Он происходит не в интернете, а в заранее сформированной базе.

К примеру, в Яндексе веб-документы, успешно прошедшие индексирование, разделяют на отдельные смысловые кластеры. Получается, что в момент, когда посетитель набирает поисковый запрос, система моментально ищет нужную информацию в конкретном кластере. далее она ранжируется (сортируется по важности) согласно заданным алгоритмам и формируются страницы выдачи, первая из которых – ТОП-10. На то какое место занимает конкретный сайт в выдаче, влияет то, насколько грамотно проведена внешняя и внутренняя оптимизация страницы под ключевые слова.

Для попадания на верхние строчки в выдаче необходимо, чтобы сайт присутствовал в индексе у целевых поисковиков. А попасть туда действительно важно, так как первые 10 ссылок собирают 95% поискового трафика.

Содержание

Как выполняется индексация

Процесс выполняется автоматически при помощи специально разработанных роботов, которых называют пауками либо краулерами. Создано несколько десятков подобных программ для разных целей, подробный перечень представлен в Яндекс. Проанализировав этот список, можно классифицировать всех роботов по назначению:

Работа пауков происходит по следующему алгоритму:

Сколько времени занимает попадание в Индекс

Время, за которое конкретный URL-адрес появляется в Индексе, зависит от ряда факторов. Ключевое значение имеет периодичность добавления изменений на нем. Индексация новостных порталов, форумов проводится за несколько минут, для них предназначены специальные быстроботы, которые реагируют на ежеминутные изменения. Если информация редко обновляется, а новые материалы практически не публикуются, то частота просмотра ботами снижается. Отсюда рекомендация оптимизаторов регулярно добавлять новые статьи и новости на продвигаемые сайты.

Как ускорить индексацию сайта в Яндекс и Google

Любой веб-сайт рано или поздно попадает в базу данных, но без грамотного подхода на это уходит достаточно длительное время. Избежать этого получится, если следовать этим правилам.

Добавить сайт в панели вебмастеров: «Яндекс.Вебмастер» и Google Search Console

Регистрация в сервисе от Yandex занимает несколько минут. Действуйте согласно инструкции:

Чтобы повысить точность данных, установите «Яндекс.Метрику» и привяжите её аккаунту Вебмастера. Данные, оказавшиеся в метрике, используются поисковым пауком.

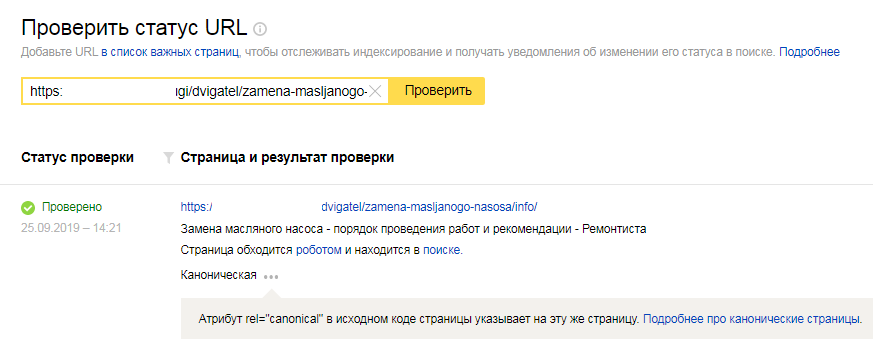

Через Вебмастер получится проверить индексацию отдельных разделов. Перейдите на вкладку «Индексирование» и найдите пункт «Проверить статус URL».

Добавление веб-страниц в Google Search Console также занимает всего несколько минут и происходит по следующей схеме:

Программы от этих поисковиков схожи по многим параметрам. Оба сервиса предоставляют пользователям доступ к отчетам о текущем состоянии индексирования. С их помощью легко отследить, какие разделы добавлены поисковиком, увидеть обнаруженные на сайте ошибке, получить рекомендации по доработкам.

Создать файл robots.txt

Поисковик даёт рекомендации:

С помощью robots.txt можно закрыть сайт от индексирования Google и открыть его только для Яндекса. Это выполняется двумя способами. Добавьте следующие правила:

Если надо распространить для всех ПС, в «User-agent» вместо поисковика, добавляют символ «*». Подробнее про настройку файла robots.txt.

Также запрет на индексацию страниц сайта реализуется с помощью мета-тегов. На странице, которую нельзя индексировать требуется прописать тег:

Создать файл sitemap.xml

Создание карты XML предусматривают все популярные CMS. Если сайт работает без движка, сделайте карту при помощи сервисов Gensitemap и XML-Sitemaps, но бесплатно можно добавить не более 1000 страниц.

Чтобы sitemap.xml действительно ускорил проверку, нужно следовать следующим правилам:

Создать HTML-карту

Ссылки на карту встречаются в подвале сайта, то есть в самом нижнем блоке, расположенным под основным контентом. Грамотно разработанная HTML-карта способствует повышению скорости сканирования ресурса поисковыми роботами и помогает им ориентироваться.

Создать понятную многоуровневую структуру

Продуманная структура также способствует повышению скорости индексирования. Чтобы она действительно помогла снизить время проверки, нужно при разработке учитывать требования ПС:

При этом стоит учитывать, что ее разработка во многом зависит от формата веб-ресурса: структуры лендинга или сайта-визитки отличаются от интернет-магазина или тематического форума.

Оптимизировать скорость загрузки

Чтобы ускорить загрузку, надо:

Определить скорость загрузки получится при помощи бесплатных сервисов. Для этих целей разработаны tools.pingdom.com и gtmetrix.com.

Создать внутреннюю перелинковку

Желательно, чтобы в отдельных разделах присутствовали ссылки на другие страницы. Если ведется перелинковка в интернет-магазине, добавьте ссылки на аналогичные и сопутствующие товары. Например, при публикации содержательных статей можно ссылаться на дополняющие материалы, опубликованные ранее, а также сделать рубрику с ссылками «Также полезно знать».

Как подобрать материал, в который может добавить ссылку на новый? Для этого используется поисковик и особый тип запроса «ключевое слово site:domen.ru», например, для это статьи можно подобрать следующие страницы для перелинковки:

Внешние сигналы

Сделайте репост опубликованного материала в социальные сети (например, личные страницы или сообщества в Facebook и ВКонтакте), добавьте ссылки на тематические форумы, доски объявлений и другие сторонние ресурсы (партнерские или спонсорские). Это позволяет поисковым краулерам быстрее обнаружить страницу. Видя, что ей поделились, он считает информацию, размещенную там полезной для пользователей, что ускоряет анализ содержимого.

Проверка индексации сайта в поисковых системах

Проверить, проиндексирован ли веб-адрес, можно несколькими способами, как через поисковики, так и с помощью сторонних сервисов.

Специальные операторы

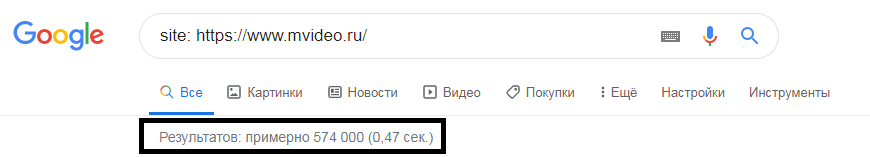

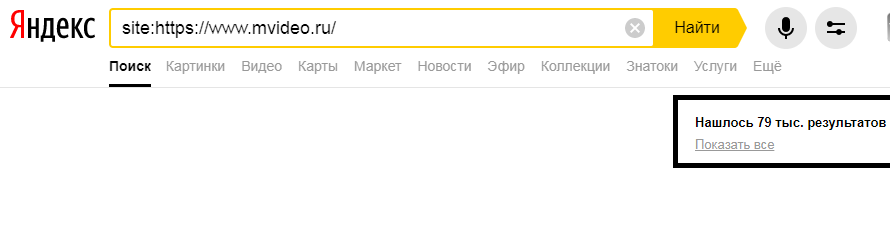

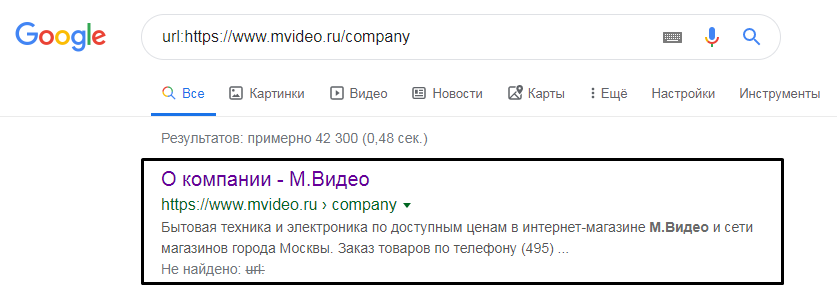

Число проиндексированных разделов через ПС получится проверить с помощью специального оператора «site:domen.ru». Для этого нужно после него в строке добавить адрес веб-ресурса. Примерное количество указано в верхней части поисковой выдачи.

«Нашлось 640 результатов», говорит о том, что в индексе поисковика 640 страниц с этого сайта.

Фраза «Результатов: примерно 603» указывает на 603 проиндексированные страницы сайта студии.

Если результаты в разных ПС сильно отличаются, это говорит, о том, что есть проблемы в обнаружении страниц роботами сайтам или других проблемах. Посмотрите на ошибки, которые указаны в сервисах для Вебмастеров.

Сервисы для вебмастеров

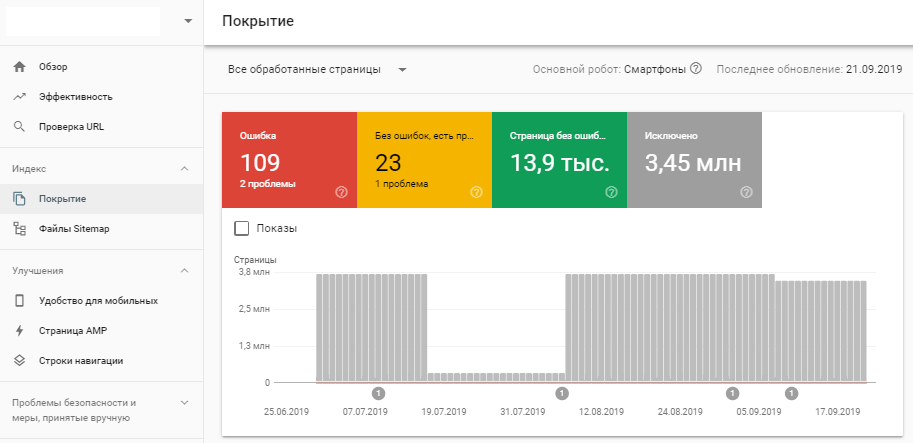

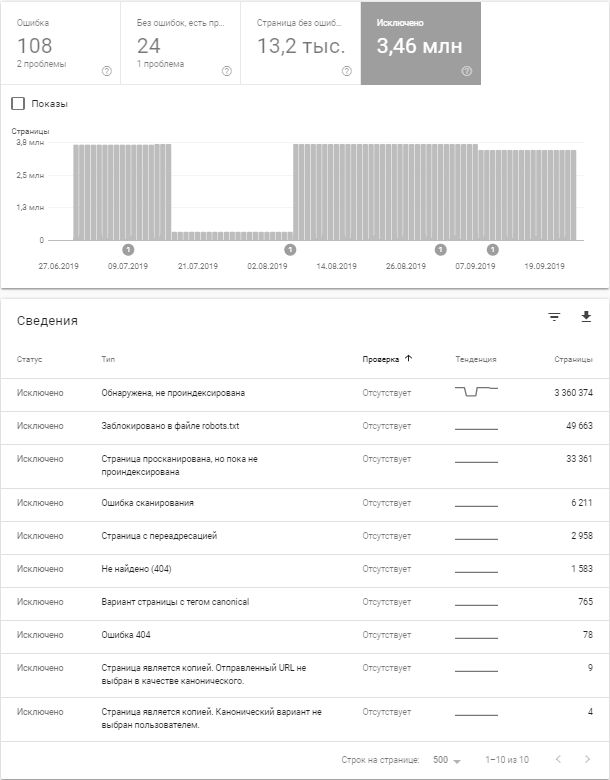

Если вы пользуетесь Google Search Console, выберите ресурс, информацию о котором хотите посмотреть, и в блоке «Индекс», кликните на «Покрытие». Так вы увидите, какие страницы попали в индекс Гугла, а на каких страницах обнаружены проблемы.

При работе с панелью для вебмастеров от Yandex надо открыть меню «Индексирование сайта» и перейти во вкладку «Страницы в поиске».

Такой метод позволяет увидеть, сколько URL-адресов попало в индекс, и отследить динамику.

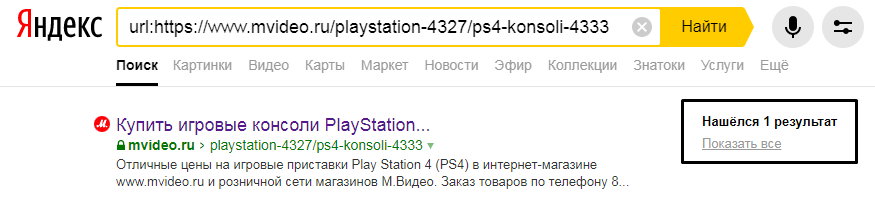

Сторонние сервисы

Выполнить проверку получится бесплатно с помощью сторонних сервисов. Для этого подходят инструменты от pr-cy.ru. Чтобы просмотреть данные об индексации, нужно указать ссылку в свободную строку и нажать «Проверить». После этого на экране появится информация о попадании в индекс, трафике, последних событиях. Ресурс показывает количество ошибок и успешных текстов.

Аналогично работают инструменты от be1.ru. Указав адрес и нажав на кнопку «Анализировать», пользователь переходит к ключевым показателям. Здесь также легко просмотреть, адаптирован ли сервис под использование на мобильных устройствах, какова скорость загрузки и динамика посещаемости.

Видеоролик про проверку и ускорению индексации

В обучающем видеоролике, который специалисты студии подготовили для SEO-марафона, идет речь про поисковую индексацию. В нем мы рассказываем, что это такое, почему она важна для SEO, а также как и где проверять индексацию сайта. Даем рекомендации по ускорению индексации страниц поисковиками.

Резюме

Исходя из этой информации, становится понятно, что индексация важна при продвижении в интернете. Если результаты Гугл и Яндекс отличаются в десятки раз, это говорит об ошибке. Из-за них роботам труднее выполнять проверку, частота которых снижается. Если в базу данных не внесена ни одна из страниц или только несколько из них, это также сигнализирует о возможных санкциях со стороны ПС. Эффективное продвижение возможно только при постоянном контроле индексации сайта и исправлении ошибок, которые усложняют доступ роботов к страницам и содержанию.

Индексация сайта в 2021: Все что важно знать

Как поисковые системы индексируют сайты в 2021?

Как изменяются подходы к оптимизации индекса сайта?

Разберем важные нюансы об индексации сайтов поисковой системой, про которые мало кто знает.

Влияние индексации сайта на позиции в поисковой выдаче

Оптимизация индекса является отправной точкой в начале работ по продвижению любого сайта.

Удалить большое количество страниц из индекса крайне сложно.

Запрет в файле robots.txt решит проблему только для Яндекс. Для Google потребуется дополнительный переобход страниц, которые следует исключить из поисковой системы.

Нет инструментов по массовому удалению страниц из индекса Google. Официальный инструмент лишь скрывают страницы из поисковой выдачи.

Как индекс влияет на ранжирование? Влияние происходит так:

Как происходит индексация сайтов?

Сначала разберемся с термином. Что такое индексация сайта? Индексация сайта — сканирование, сохранение страниц в базу поисковой системы и дальнейшая обработка алгоритмами.

Процесс индексации сайта в упрощенном виде:

На практике схема индексации намного сложнее. Разберем как проходит процесс индексации на примере Google.

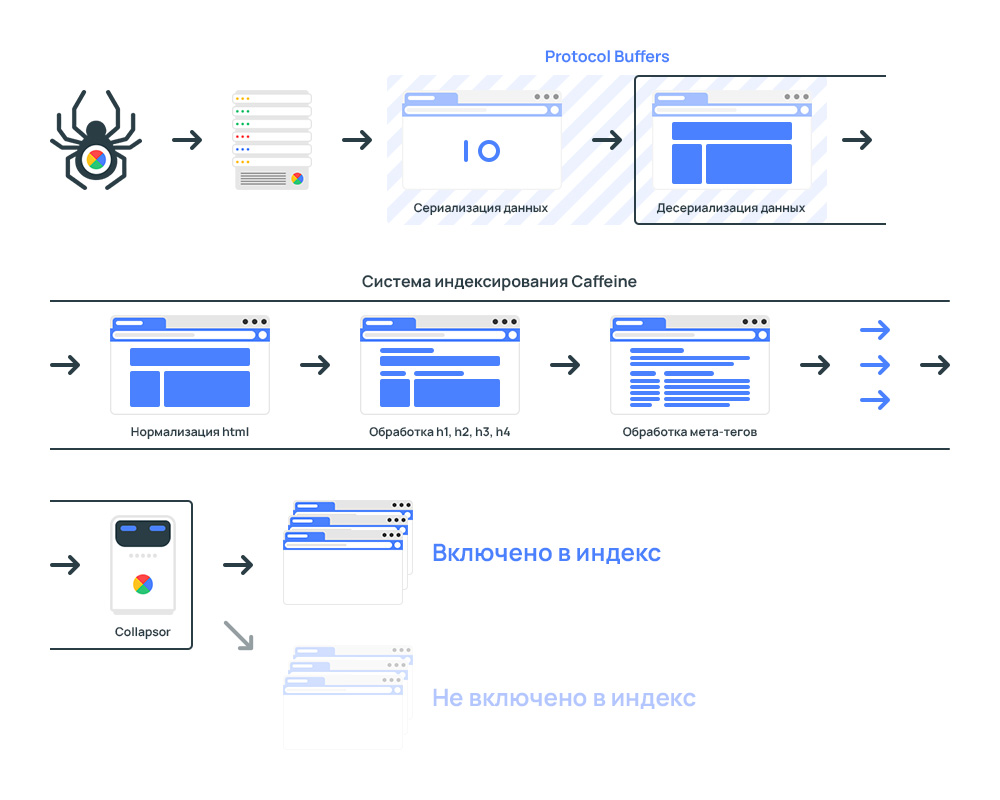

В процессе индексации участвует три отдельных системы: планировщик, робот для сканирования сайтов и система обработки.

Google Scheduler создает план на индексацию с учетом краулингового бюджета на сайт.

Googlebot сканирует сайты и сохраняет данные в бинарном виде.

Google Caffeine — система обработки проиндексированных страниц. Задача системы заключается в приеме, обработке и распределении страниц сайтов по индексам.

Каждую секунду Caffeine обрабатывает сотни тысяч страниц параллельно. Процесс индексации происходит постоянно. Индекс обновляется частями.

Что происходит внутри Caffeine?

Как работает Google Caffeine

Весь процесс системы индексирования:

Сначала происходит выгрузка данных, которые собрал поисковый краулер Googlebot.

Для скорости обработки данные передаются в бинарном виде, то бишь применяется процесс перевода структуры данных в последовательность байтов.

Для обработки данных применяется Protocol Buffers.

Protocol Buffers — протокол сериализации (передачи) структурированных данных, предложенный Google как эффективная бинарная альтернатива текстовому формату XML

После получение данных система индексации конвертирует данные в специальный формат, который способны анализировать роботы.

Страница передается в лексер. Предназначение лексера в поиске и исправлении ошибок в коде страницы.

Часто на сайтах встречаются ошибки в коде. Провести анализ контента со страниц с ошибками нет возможности технически.

С целью устранения ошибок код анализируются через HTML-лексер и автоматически исправляются.

Ошибки в верстке страницы напрямую никак не влияют на ранжирование.

Далее происходит нормализация данных. Страницы разбиваются на фрагменты. Например:

Google Collapsor в системе индексации сайтов

Collapsor является подсистемой в системе индексации.

Collapsor определяет куда переместить страницу. Варианты:

Именно Коллапсер присваивает страницам статус soft 404.

Коллапсер фильтрует индекс от бесполезных страниц: товар отсутствует, дубли, технические страницы и прочее.

Как обнаруживаются страницы дубли? Через анализ контрольной суммы checksum для каждой страницы, который основан на словах на странице. В результате, если есть две страницы с одинаковой контрольной суммой, то анализатор расценивает как дубли.

Индексация сайта гарантирует только обработку страниц. Попадание страниц в поисковую выдачу зависит от оценки страниц Google Коллапсером.

На основе Serving Index формируются результаты поисковой выдачи.

Google Serving Index — Индекс обслуживания

Индекс обслуживания или Serving Index — основной индекс поисковой системы состоящий из страниц, которые участвуют в ранжировании.

Находится в отдельных дата-центрах, откуда пользователи получают результаты поиска.

Документ попадает в Serving Index если:

Проверка индексации сайта в Яндекс с учетом всех поддоменов сайта:

Проверка индексации в Яндекс по разделу:

Проверка индексации сайта в системе Google с учетом всех поддоменов сайта:

Проверка индексации по разделу:

С учетом вхождений в заголовки:

Проверка индексации по разделу:

Если страницы перестали открываться, то такие страницы подлежат удалению из индекса.

Если сайт отдает код ошибки, то страницы удаляются из индекса.

Уязвимость могут эксплуатировать конкуренты по выдаче.

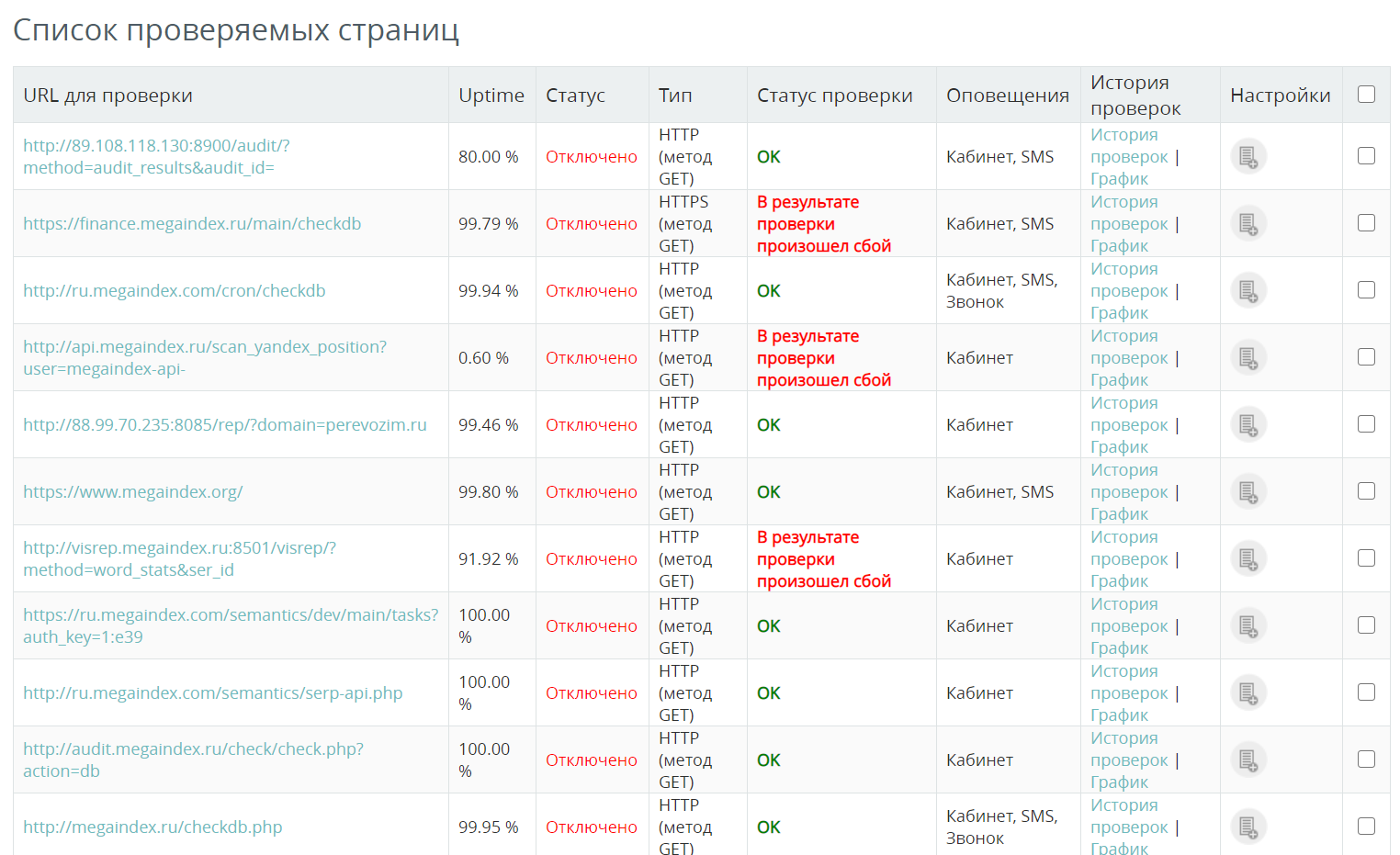

Как проверить доступность сайта? К примеру, можно использовать сервис от MegaIndex. Стоимость 1 проверки составляет 0.01 рублей. Если сервер сайта перестанет работать, система уведомит об инциденте удобным способом.

Вопросы и ответы

От чего зависит количество страниц подлежащих индексации?

Максимальное количество страниц, подлежащих индексации при очередном обходе сайта роботом определяет метрика под названием краулинговый бюджет.

Значение рассчитывает планировщик сканирования.

Как изменяются в подходы по оптимизации индекса?

Подходы к оптимизации индекса сайта действительно изменяются. К примеру, если раньше наличие большого объема страниц в поисковой выдаче сказывалось положительно на продвижении, то теперь ситуация обстоит иначе.

Большое количество страниц в индексе позволяло создавать на сайте значимый ссылочный статический вес. Сигнал передавался через ссылки на важные внутренние страницы. В результате ранжирование важных страниц улучшалось.

Но алгоритмы поисковых систем были улучшены. Тактика перестала быть эффективной. Большое количество страниц на сайте имеет смысл только в случае, если страницы способны приносить трафик.

Выводы

Задача по улучшению индексация сайта требует внимания, поскольку влияет на позиции сайта в поисковой выдаче.

Через сигналы Web Vitals на ранжирование могут влиять даже страницы, которые закрыты в robots.txt.

Открытыми к индексации должны быть такие страницы:

Приведенная информация является достоверной и подтвержденной из официальных источников.

В других поисковых системах процесс индексации схожий.

Если интересно узнать как найти на сайте бесполезные страницы и удалить страницы из индекса поисковой системы, напишите в комментариях.

Если остались вопросы по теме, напишите в комментариях.

Индексация сайта: отслеживание, управление и рекомендации

Индексация сайта

На сегодняшний день во Всемирной паутине насчитывается около 1,7 миллиарда веб-сайтов, и из них около 200 миллионов являются активными (данные https://www.internetlivestats.com). Чтобы выдать максимально релевантный ответ на запрос пользователя, поисковые системы должны просканировать, занести в базу и сравнить между собой документы с каждого сайта. Сравнение осуществляется по факторам ранжирования: техническим (возраст домена, скорость загрузки), ссылочным, контентным (заголовки, ключевые слова), поведенческим, социальным и многим другим. Поэтому так важно, чтобы в процессе индексации в базу поисковых систем попадали только качественные и проработанные страницы.

Узнать о существовании ресурса поисковики могут напрямую — если вы добавите свой сайт в панели веб-мастеров — или же более «естественным» способом — от ресурсов, которые уже находятся в базе.

Процесс индексации — один из самых важных этапов при поисковой оптимизации сайта. Ведь прежде, чем страницы попадут в базу поисковых систем и начнут ранжироваться в выдаче, они должны быть проиндексированы.

Индексация — это процесс сканирования сайта поисковыми роботами и добавления его страниц в базу данных поисковых систем, где в дальнейшем происходит обработка страниц с помощью алгоритмов.

Поисковый робот обрабатывает всю доступную ему информацию: текстовые фрагменты, картинки и другие документы, сохраняя их на сервере поисковой машины. Он самостоятельно определяет, какие сайты и как часто нужно посещать, какое количество страниц следует обойти на каждом из них. Роботы не обходят весь сайт за один раз, особенно если это крупный ресурс, содержащий тысячи страниц. Такое поведение связано с тем, что краулерам нужно обойти большое количество страниц на разных сайтах и не перегрузить серверы своими запросами. Основываясь на этой особенности появился такой показатель как краулинговый бюджет.

Краулинговый бюджет — количество страниц, которые может просканировать поисковый робот за один визит на сайт.

Факторы, которые уменьшают краулинговый бюджет:

Ресурсы сервера затрачиваются на обработку данных страниц, что, в свою очередь, приводит к снижению активности сканирования действительно важных URL. В итоге это может привести к тому, что качественный контент сайта будет индексироваться с задержкой или в принципе не попадет в индекс.

Подробнее об оптимизации краулингового бюджета можно прочитать тут.

Отслеживание индексации

Очень важно следить за индексацией ресурса: только владея информацией о статусе страниц вашего сайта, можно эффективно управлять индексацией. Чтобы проверить корректность индексации, вы можете использовать следующие инструменты:

Google Search Console

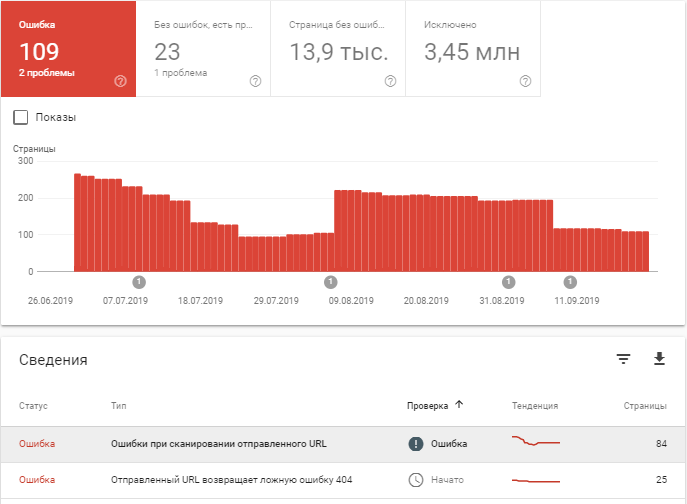

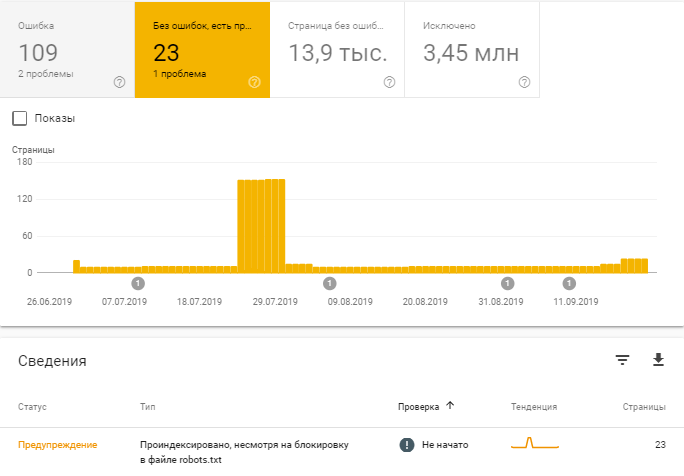

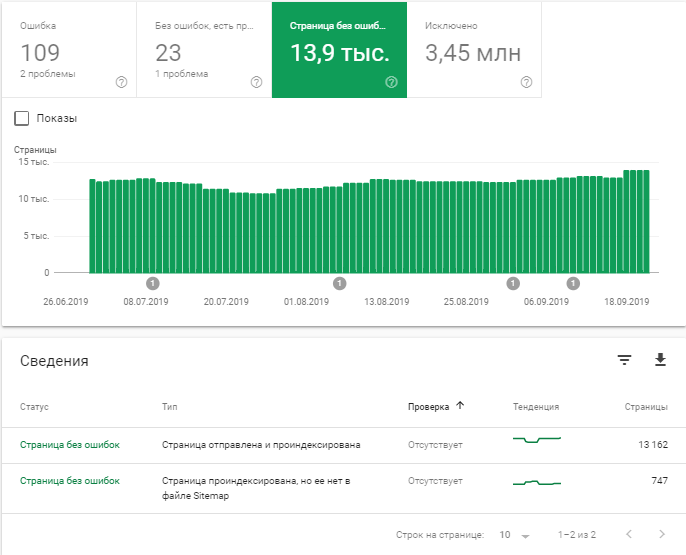

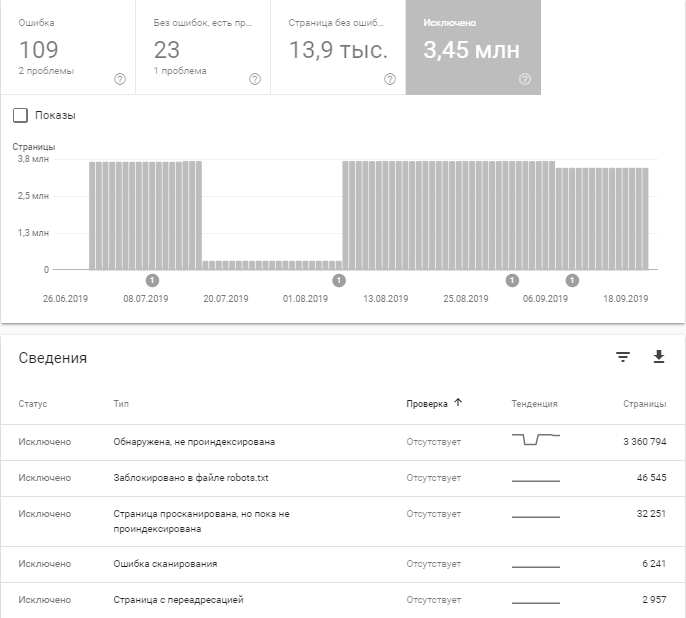

Необходимо авторизоваться в Search Console и в разделе «Индекс» выбрать «Покрытие».

В Google Search Console есть возможность проанализировать ряд моментов:

Например, после последнего обновления можно узнать, какие страницы проиндексированы, несмотря на блокировку в robots.txt.

В следующем разделе мы рассмотрим самые распространенные причины исключения страниц из индекса.

«Яндекс.Вебмастер»

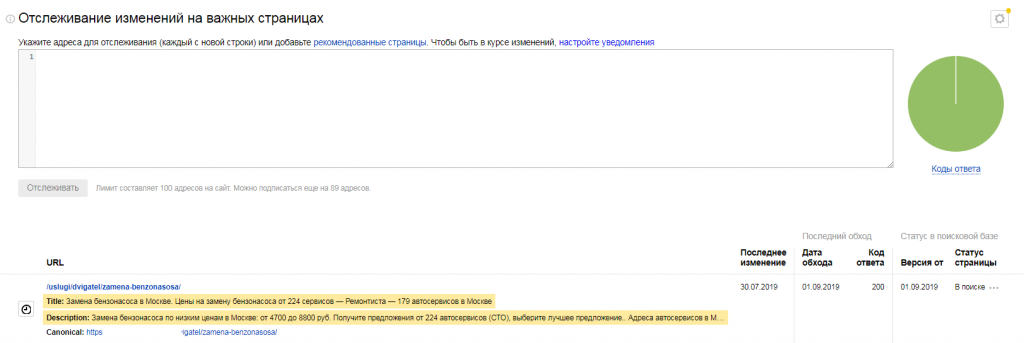

В «Яндекс.Вебмастере», в разделе «Индексирование» доступно большое количество отчетов и инструментов, с помощью которых можно:

В панели под графиком вы можете выбрать интересующий вас промежуток времени;

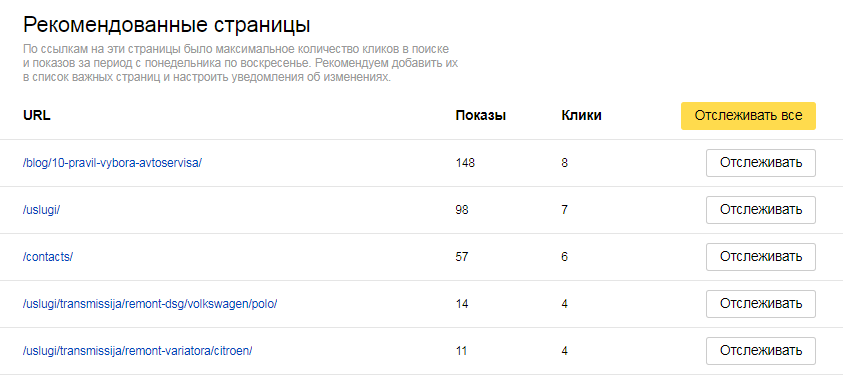

С помощью этого инструмента можно следить за статусом особо важных для продвижения страниц, в том числе отслеживать дату последнего посещения роботом, код ответа сервера, статус в поисковой базе. Основываясь на количестве кликов в поиске и показах за определенный период, поисковая система порекомендует страницы, которые следует добавить в список важных;

Поисковые операторы

Самый простой способ узнать общую информацию о страницах в индексе поисковых систем — это обратиться к ПС напрямую. Для этого используются специальные поисковые операторы, которые позволяют ограничить область поиска отдельными доменами, языками, типами файлов и т.д. Процесс сбора информации через поиск — гибкий и позволяет оценить количество страниц в индексе не только своего сайта, но и любого другого, например, ресурса конкурентов.

Рассмотрим основные операторы:

Для более детального анализа вам могут понадобиться такие операторы, как:

Подробнее об операторах вы можете прочитать в справках «Яндекса» и Google.

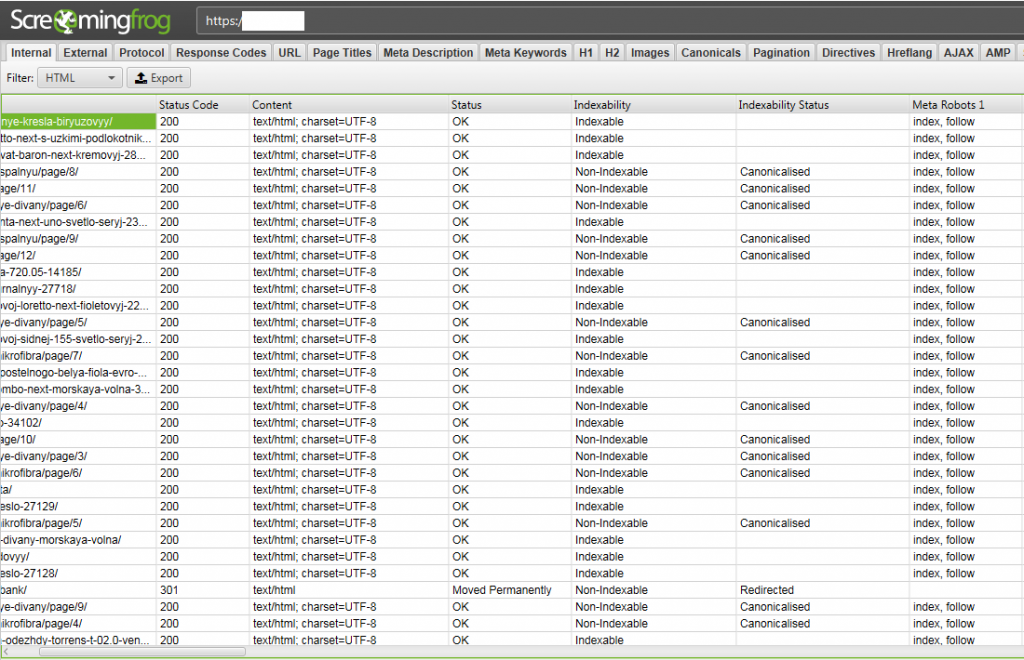

Проверка индексации с помощью расширения для браузеров

RDS-бар — это плагин для Google Chrome и Mozilla Firefox, который прямо в окне браузера отображается в виде дополнительной панели инструментов. Этот плагин позволяет быстро просмотреть основные показатели ресурса.

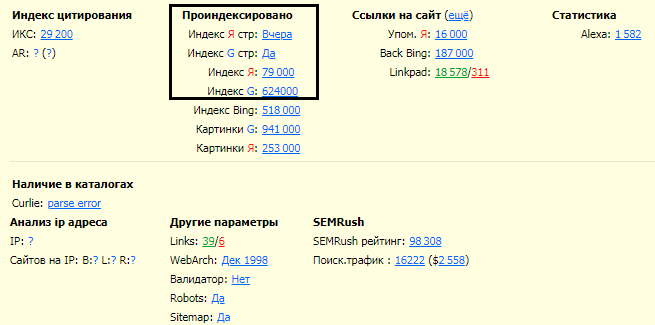

Программы для проверки индексации

Существует большое количество многофункциональных сервисов-парсеров, с помощью которых можно автоматизировать процесс анализа внутренних ошибок ресурса и проблем индексации. Среди таких сервисов — Netpeak Spider, Comparser, Screamingfrog и т.п.

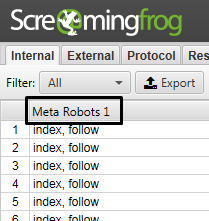

Скриншот ниже представляет пример отчета парсера Screamingfrog. Мы видим, что сервис предоставляет разную информацию о странице: код ответа сервера, её тип, индексируется страница или нет, настроены ли канонические URL, и многое другое.

Каждый из перечисленных сервисов предоставляет бесплатный пробный период, на протяжении которого вы можете испробовать все инструменты. В итоге вы будете использовать на постоянной основе тот сервис, что полностью отвечает вашим требованиям.

Причины исключения страниц из индекса

Выпадение продвигаемых страниц из индекса, и как следствие из поиска, влечет за собой падение позиций сайта в выдаче и снижение поискового трафика, поэтому так важно следить за индексацией страниц.

Рассмотрим распространенные причины выпадения страниц из индекса.

Нарушения на сайте

Поисковые системы устроены таким образом, что хорошо индексируют и ранжируют только качественные ресурсы, которые могут дать максимально релевантный ответ на запрос пользователя. На сайты, которые пытаются обмануть поисковые системы, могут быть наложены ограничения специальными алгоритмами. Эти ограничения могут влиять на индексирование и ранжирование сайта и приводить к массовому исключению страниц из индекса.

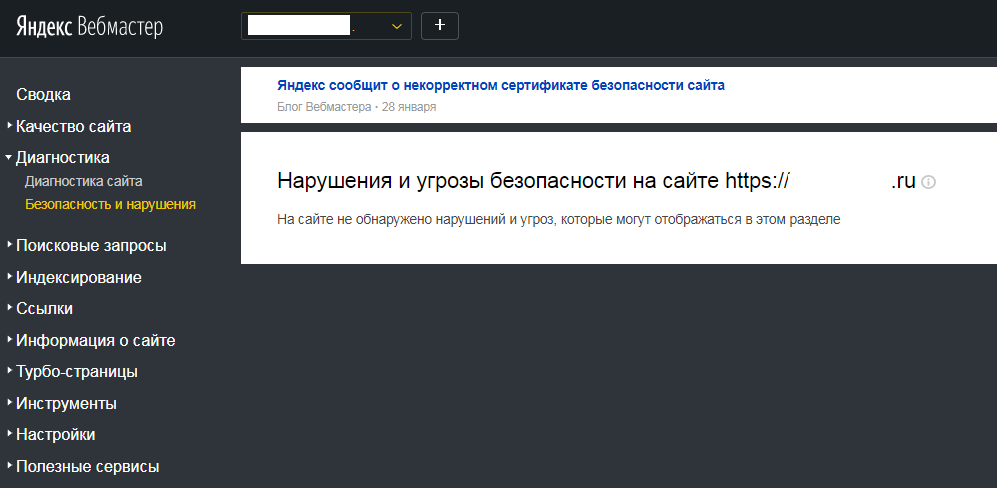

Проверить, есть ли нарушения или угрозы безопасности на сайте, можно, например в «Яндекс.Вебмастере», в разделе «Диагностика» —> «Безопасность и нарушения».

Ошибки на страницах

Поисковые системы могут исключить страницы из индекса из-за ошибок в коде, ответа сервера и по многим другим причинам. Рассмотрим распространенные ошибки индексации отдельных страниц в «Яндексе» и в Google.

Ошибки индексации в «Яндексе»:

Ошибки индексации в Google:

Если поисковая система исключила из индекса продвигаемые страницы вашего сайта, необходимо выяснить причину выпадения и устранить ее, отправить страницы на повторную индексацию.

Как можно ускорить процесс индексации?

Ускорение индексации — комплекс работ, которые направлены на ускорение процессапоявления страниц ресурса в поисковой выдаче. Это касается как новых, так и обновленных страниц сайта. Если страницы технически оптимизированы, на них регулярно обновляется контент, на сайте организована понятная и простая структура, но при этом страницы очень медленно индексируются поисковыми системами, то ускорить процесс можно, используя перечисленные ниже методы.

Формирование и настройка файла sitemap.xml

Файл sitemap.xml сообщает поисковым роботам информацию о страницах, доступных для сканирования.

Разместив этот файл на сайте, вы можете сообщить поисковым роботам следующую информацию:

Пример передачи информации о странице:

http://www.site.com/page1.html 2000-01-01 daily

Требования к файлу sitemap.xml:

Внутренняя перелинковка

Внутренняя перелинковка — это процесс связывания страниц сайта между собой с помощью гиперссылок. Перелинковка обеспечивает структурную целостность ресурса и оказывает значительное влияние на индексирование страниц сайта.

Примеры внутренней перелинковки:

Внешняя оптимизация

Подразумевает размещение на сторонних площадках ссылок на страницу. Принцип действия такой же, как у внутренней перелинковки, только связываются между собой не страницы одного сайта, а страницы разных сайтов.

Внешняя оптимизация включает:

Добавление страницы в индекс вручную

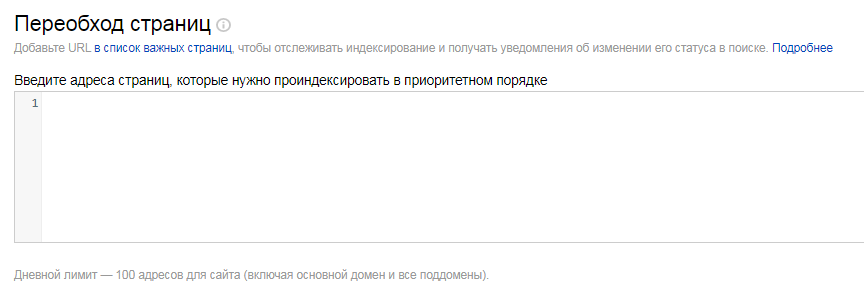

Добавить страницу в индекс можно с помощью таких инструментов, как «Переобход страниц» для поисковой системы «Яндекс» и «Проверка URL» для Google. Последний инструмент сработает при условии, что отсутствуют причины, по которым страница выпала из индекса поисковых систем.

Управление индексацией

Для того чтобы контролировать расход краулингового бюджета, необходимо корректно настроить индексацию сайта. Существует несколько способов рассказать поисковому роботу, что индексировать, а что нет.

Robots.txt — текстовый файл, содержащий инструкции для роботов поисковых систем. Он является первым файлом, к которому обращаются краулеры, чтобы понять, можно ли индексировать ресурс. Однако они воспринимают файл не как набор четких инструкций, а только как рекомендации.

Признаки корректно настроенного robots.txt:

Рекомендуется использовать общие инструкции, охватывающие сразу все типовые страницы, которые нужно скрыть от индексации. Идеальный «роботс» — это краткий по содержанию, но богатый по смыслу файл.

Примеры правил для определенного типа страниц:

Подробнее о файле robots.txt и его размещении можно узнать из официальных источников: Справка Google по файлу robots.txt, Справка «Яндекса» по использованию robots.txt.

Метатег robots и HTTP-заголовок X-Robots-Tag

Внедрение метатега robots в код страницы позволяет управлять индексацией конкретной страницы, а также содержимого и ссылок, расположенных на ней.

В атрибуте name можно указывать правила для разных поисковых систем:

Как кажется на первый взгляд, метатег robots имеет те же возможности, что и настройка файла robots.txt, но некоторые различия все же есть:

Управлять индексацией страниц можно, одновременно используя метатег robots и файл robots.txt. Они могут давать инструкции поисковым роботам для разных страниц сайта или же дублировать команды друг друга. Но если будут присутствовать противоречивые инструкции для одной страницы, то по умолчанию будет выбираться более строгое правило. При конфликте между двумя директивами, приоритет отдается положительному значению.

Ниже дан список директив, которые поддерживаются поисковыми системами.

| Директива | Описание | Метатег robots | Заголовок X-Robots-Tag |

|---|---|---|---|

| noindex | Не индексировать текст страницы. Страница не будет участвовать в результатах поиска. | ✅ | ✅ |

| nofollow | Не переходить по ссылкам на странице. | ✅ | ✅ |

| none | Соответствует директивам noindex, nofollow. | ✅ | ✅ |

| noarchive | Не показывать ссылку на сохраненную копию в результатах поиска. | ✅ | ✅ |

| noyaca | Не использовать сформированное автоматически описание. | ✅ | ❌ |

| index | follow | archive | Отмена соответствующих запрещающих директив. | ✅ | ❌ |

| all | Соответствует директивам index и follow. Разрешено индексировать текст и ссылки на странице. | ✅ | ❌ |

*Таблица с сервиса «Яндекс.Помощь»

Заголовок X-Robots-Tag — элемент HTTP-заголовка, который можно настроить для определенной страницы. Проверить наличие заголовка и указанную директиву вы можете с помощью Screamingfrog. Как было сказано выше, сервис собирает большое количество информации о страницах, в том числе и по X-Robots-Tag.

Пример настройки заголовка X-Robots-Tag:

X-Robots-Tag: noindex, nofollow — запрет индексации и перехода по ссылкам на странице.

По сути, это тот же самый метатег robots, но действует на уровне заголовков сервера и распространяется на любые типы содержимого, при этом директивы почти такие же, как у метатега robots.

Атрибут rel=»canonical»

Если на сайте есть страница, доступная по нескольким адресам, а также страницы с одинаковым или похожим контентом, то поисковые системы могут посчитать их дублями. Поисковые системы объединяют такие страницы в группу дублей и выбирают для показа в результатах поиска только одну из них, наиболее информативную и релевантную поисковым запросам. И это не всегда та страница, которая вам нужна.

Чаще всего такая ситуация происходит со страницами пагинации и фильтрации.

Вы можете указать роботу страницу, предпочитаемую для показа в результатах поиска, с помощью атрибута rel=»canonical». Для настройки канонических страниц нужно в теге в коде страницы, которая является полным или частичным дублем, прописать следующий код:

URL страницы, которая должна участвовать в поиске, должен быть указан в атрибуте href.

Использование атрибута rel=»canonical» не позволяет экономить краулинговый бюджет. Поисковым роботам все равно приходится сканировать страницу для проверки отличий от канонической.

Удаление страницы вручную с помощью веб-мастеров

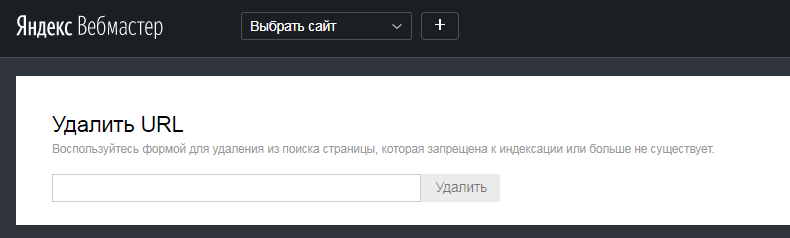

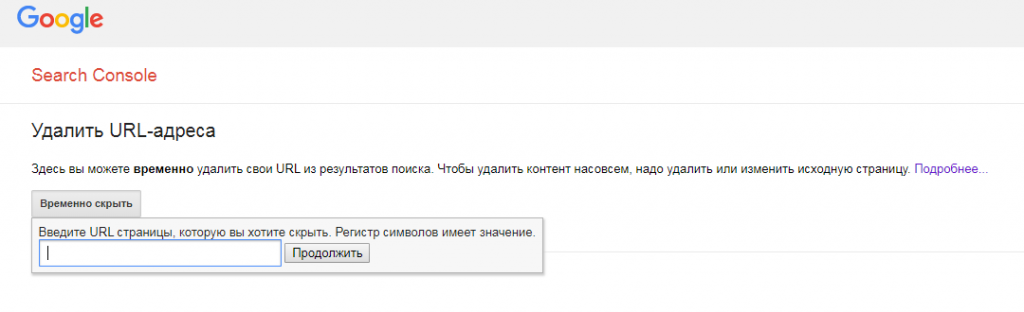

В «Яндекс.Вебмастере» и Search Console есть инструменты, позволяющие удалить из поиска URL страницы, которая запрещена к индексации или не существует.

Ошибка 4xx

Пожалуй, самый простой способ удаления страницы из поиска — это удаление ее со своего сайта. С условием, что при обращении к старому URL, сервер будет выдавать определенный ответ. Для исключения страниц используются несколько статус-кодов, самые распространенные из них: 403, 404 и 410.

Если при удалении страницы из поиска нужно, чтобы она оставалась на сайте, то этот способ не подходит.

Что нужно скрывать от поисковых систем?

Если ваш сайт только в процессе создания, то лучше закрыть его от поисковиков полностью, используя соответствующие правила в robots.txt:

Рекомендуется «отдавать» поисковикам только наполненные и оптимизированные страницы, при этом есть ряд страниц, которые следует скрывать от поисковых систем постоянно. В первую очередь это технические и административные страницы, предназначенные для управления контентом, сбора статистики и т.п. А также страницы, содержащие персональную информацию пользователей: страницы входа в личный кабинет и регистрации, корзина товаров, формы и т.п.

Еще страницы, которые следует закрыть от индексации:

Индексация сайта — сложный и важный процесс, и поисковые системы далеко не всегда могут разобраться в принципах индексации вашего ресурса самостоятельно. Нужно добиваться корректной индексации, используя все доступные методы управления. Очень важно вовремя удалять из индекса некачественные страницы и дубли, которые размывают релевантность целевых страниц сайта. Не стоит забывать и о динамике индексации страниц вашего ресурса. Если страницы стали значительно медленнее индексироваться, или разница между количеством страниц в индексе разных поисковых систем больше 10%, значит, существуют проблемы с индексацией в одной из систем. Также не стоит забывать, что поисковики развиваются и стараются максимально упростить процесс взаимодействия поисковых роботов с сайтами. Не пренебрегайте возможностями инструментов панелей веб-мастеров.